의료인공지능에 대한 개괄적 소개와 의료인공지능 사업에 대한 이해 - Part 1

들어가며

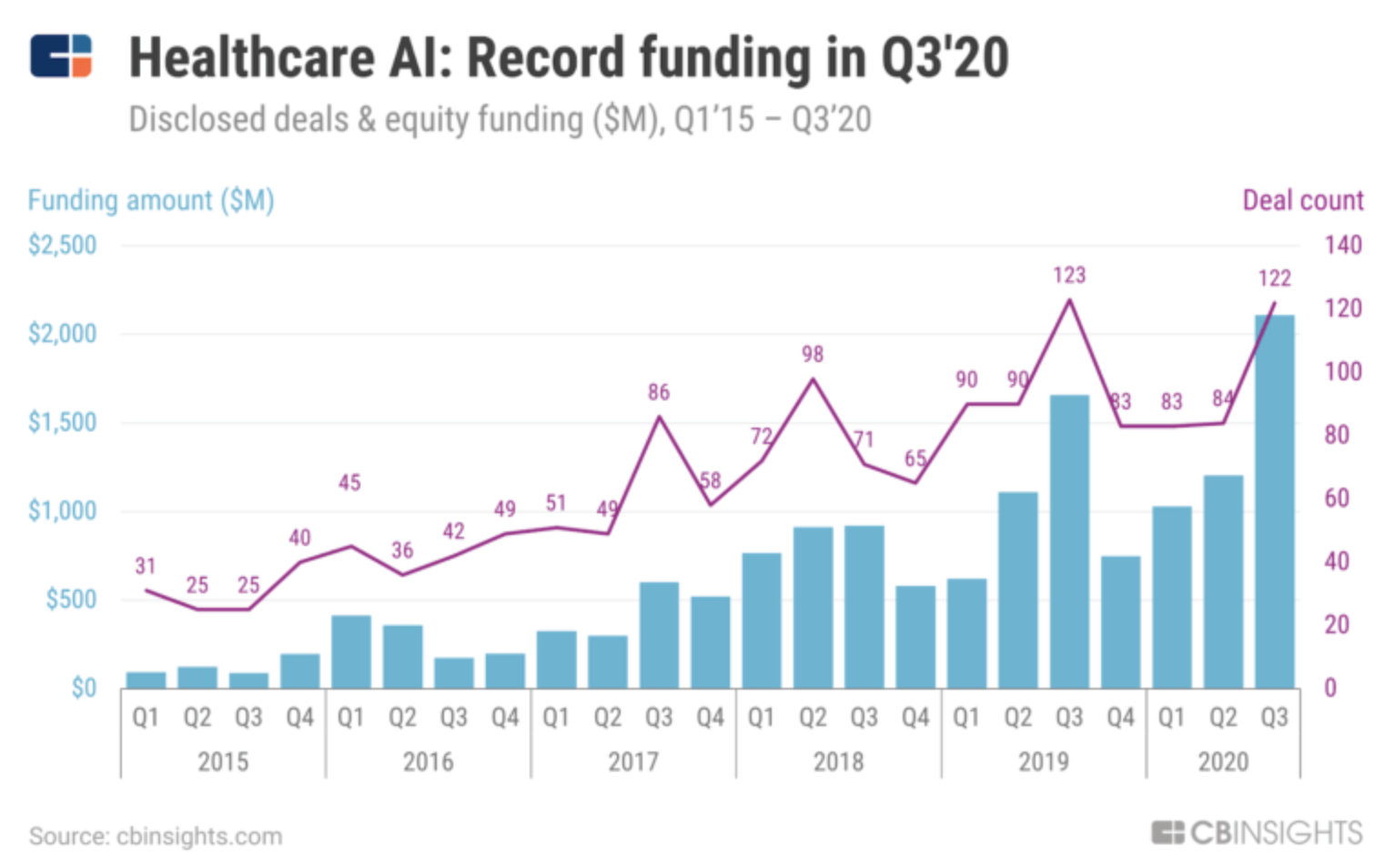

인공지능 산업계의 큰 분야를 몇 가지로 나누라면 자율주행, 로보틱스, 제조업, 그리고 꼭 빠질 수 없는 것이 의료인공지능입니다. 의료인공지능 산업계는 인공지능이 급부상한 이후 지난 10년간 폭발적으로 성장했습니다. 일례로 cbinsight라는 곳에서 조사한 자료에 따르면

의료인공지능에 대한 투자는 크게 성장하고 있는 추세이고 기술들도 포화에 가까울 정도로 수많은 연구들이 수많은 주제에 대해 진행되고 있습니다. 이렇게 부상하고 있는 의료인공지능은 얼마나 발전했고, 무엇이 허들이며 실제 의료를 바꾸기 위해 해야 하는 고민들은 무엇일까요?

이 글에서는 의료인공지능에 대한 발전을 개략적으로 살펴보고 기술과 한국의 의료인공지능 산업계에 대한 이해를 하는 것을 목표로 삼아 봅니다.

의료인공지능, 그리고 의사의 미래

의료인공지능 연구를 시작하면서 제가 의사, 의대생들에게 많이 들었던 말은

그거 상용화되면 의사 망하는거 아님?

이었습니다. 의사는 정말 의료인공지능으로 인해서 일자리가 위협받게 될까요? 다음 질문을 생각해봅시다.

(의료)인공지능은 도메인 전문가(의사)를 대체할 수 있을까?

의료인공지능은 의사를 대체할 수 있을까?

사람마다 의견이 갈릴것 같습니다. 먼저 대가들은 어떻게 생각하는지 살펴봅시다. 먼저 살펴볼 대가는 딥러닝의 대부, 제프리 힌튼입니다.

Machine Learning and Markets for Intelligence, 2016

제프리 힌튼은 2016년 Machine Learning and Markets for Intelligence라는 곳에서 다음과 같이 말했습니다. (유튜브 링크)

Let me start by saying a few things that seem obvious. I think if you work as a radiologist, you’re like the coyote that’s already over the edge of the cliff but hasn’t yet looked down, so doesn’t know there’s no ground underneath him. People should stop training radiologists now. It’s just completely obvious that within 5 years, deep learning is going to do better than radiologists, because it’s going to be able to get a lot more experience. It might be 10 years, but we’ve got plenty of radiologists already.

한글로 번역하면 다음 정도의 말이 되겠죠.

명백하게 보이는 몇 가지 얘기부터 하겠습니다. 만약 당신이 영상의학과 의사로 일한다면, 당신은 벼랑 끝에 서있지만 아직 아래를 내려보지 않아서 바로 앞에 땅이 없다는 사실을 모르는 코요테와 같습니다. 영상의학과 의사를 훈련하는 것을 우리는 멈추어야 합니다. 명백한 사실은 5년 안에, 딥러닝은 영상의학과 의사보다 더 잘 할 것이고, 이는 딥러닝이 더 많은 경험을 할 것이기 때문입니다. 10년이 될 수도 있지만, 영상의학과 의사들의 수는 충분합니다.

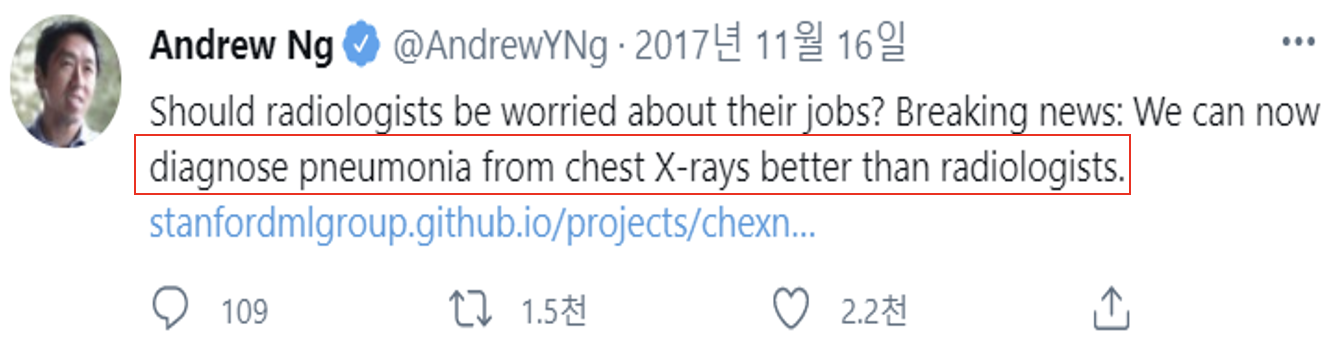

짧으면 5년, 길면 10년 내에 영상의학과가 딥러닝, 인공지능으로 대체될 것이라는 이야기를 하고 있습니다. 다른 대가의 의견도 살펴봅시다. 이번에 살펴볼 사람은 Coursera의 Machine Learning 강의로 유명한 스탠포드의 앤드류 응 교수님입니다.

앤드류 응 교수님은 영상의학과보다 흉부 X선 사진에서 폐렴을 인공지능이 더 잘 진단할 수 있다고 무려 2017년에 말씀하셨군요. 저 트윗 아래의 링크에 들어가면 다음과 같은 페이지가 나옵니다.

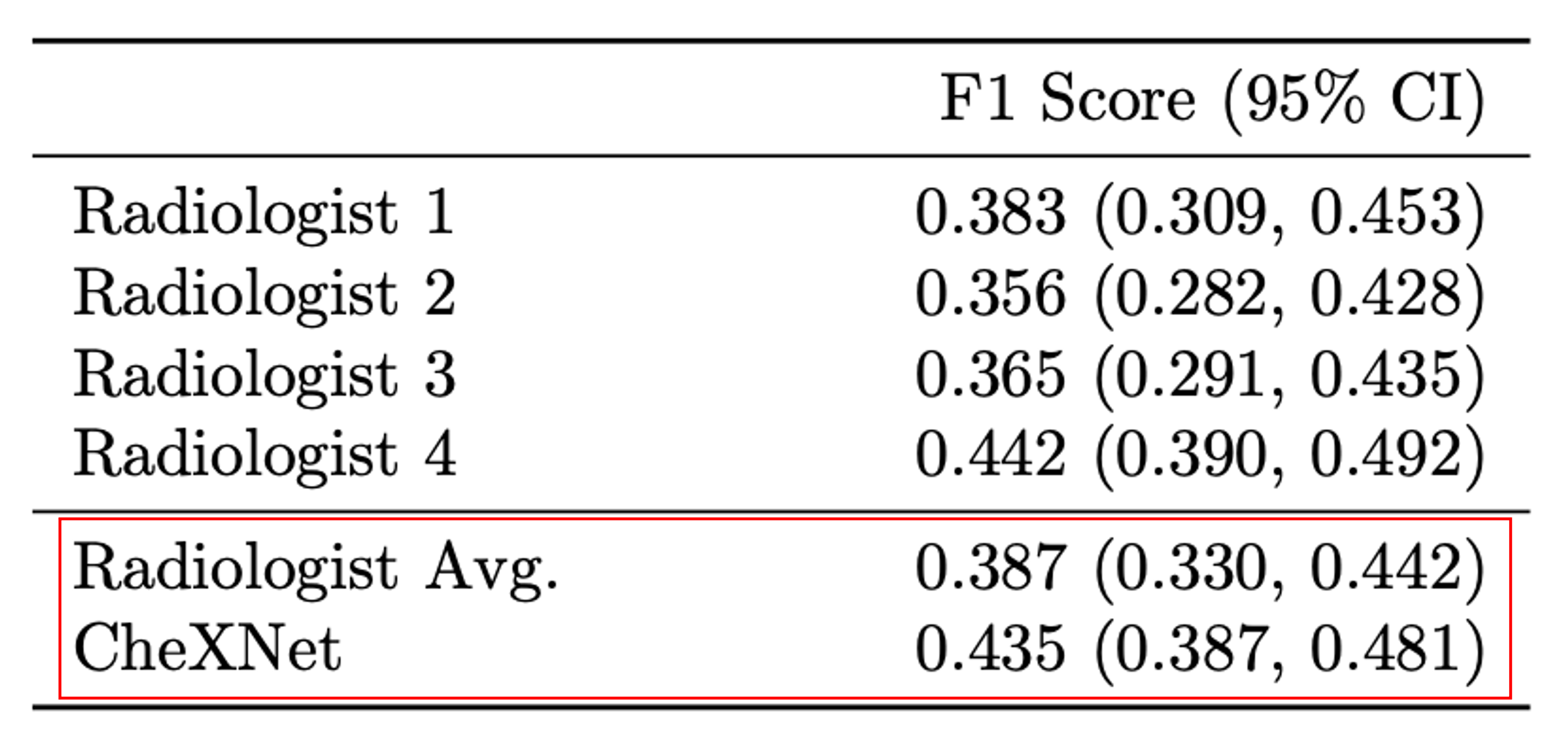

이 페이지에 링크된 논문으로 들어가면 다음과 같은 주장을 하는 것을 볼 수 있습니다.

F1 Score가 뭔지는 모르겠지만, Radiologist(영상의학과 전문의)보다 CheXNet이 더 성능이 높다는 것은 알 수 있을거 같습니다. 그러니까, 영상의학과 전문의보다 딥러닝이 더 잘한다는 말 정도를 하는것 같네요. 무려 2017년에!

여기서 잠시 생각을 해 보겠습니다. 폐렴이라는 질환은 다른 말로 하면 하기도감염이 됩니다. 즉, 기도의 아랫쪽에 감염이 생긴다는 말이지요. (대비되는 말은 상기도감염, 혹은 감기가 됩니다.) 그런데 폐렴은 몰라도 감기는 다들 한 번쯤 걸려보셨을 것이기 때문에 그 당시를 생각해보면, 우리가 감기에 걸린다고 아주 돈이 비싸거나 무거운 장비로 검사를 하지는 않았습니다. 폐렴도 아주 같지는 않지만 아주 다르지도 않습니다. 환자가 기침을 하고, 가래가 끓고, 열이 나고, 폐렴이 의심되면

- 일단 (광범위) 항생제를 쓰고

- PCR, 세균 배양, 항원검사법 등을 통해 원인 균을 파악하며 (이를 통해 균주에 맞는 적절한 항생제로 치료 방침을 변경하기도 합니다.)

- 보조적인 수단으로 흉부 X선 검사나 흉부 CT를 찍습니다.

그러면 여기서 앤드류 응 교수님 그룹이 한 연구는 이 중 무엇에 대해서 연구를 한 것일까요? 바로 진단의 gold standard인 세균 파악이 아닌 보조 진단인 흉부 X선 검사와 흉부 CT에 대해서, 그 중에서도 정확도가 CT에 비해서 낮은 흉부 X선 검사에 대해 영상의학과 의사보다 잘 한다는 것을 보인 연구입니다. 요약하자면, 보조적인 진단 수단 중에서도 정확도가 상대적으로 떨어지는 수단에 대해 전문가 그룹보다 잘 한다는 것을 주장한 것이지요.

질문 바꿔보기

이런 대가들의 의견을 바탕만으로 결론을 내리기 전에 논문을 한 편 살펴봅시다. (링크)

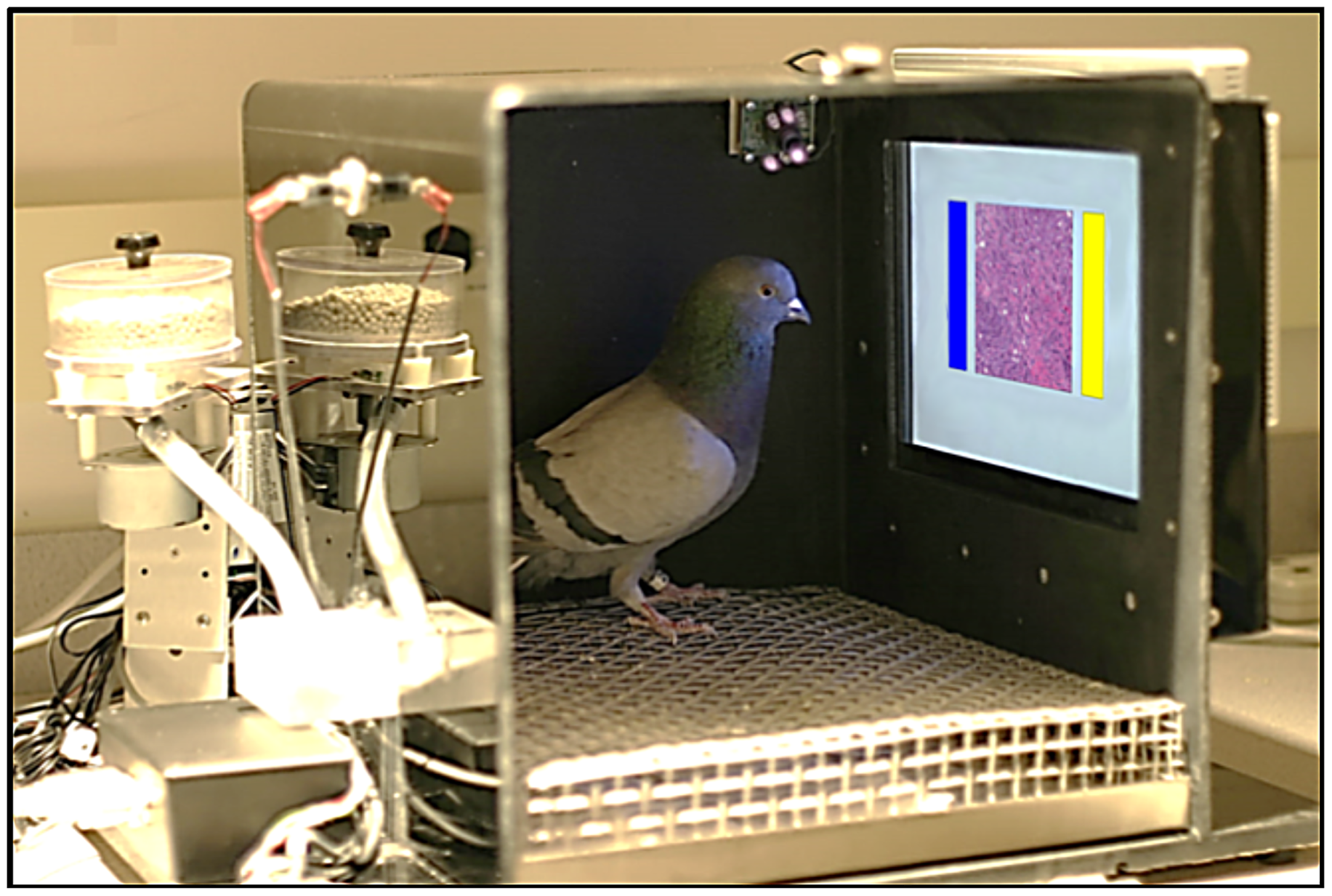

논문 제목이 자극적입니다. 우리 말로 번역하자면 [유방암의 영상의학, 병리 이미지에 대한 비둘기의 학습 능력] 정도로 의역할 수 있겠네요. 잘 아는 사실이지만, 의학 지식은 획득하기가 어렵습니다. 의대를 졸업하고, 인턴을 하고, 레지던트까지 도합 6+1+4=11년을 꼬박 달리고 나서야 의학이라는 방대한 바다의 한 부분에 대한 전문의 자격증을 딸 수 있게 되는 것이지요. 그런데 그 중에서도 병리과와 영상의학과는 눈으로 이미지를 보는 것이 주된 업무입니다. 즉, 시각 시스템을 잘 활용하여 의학적 진단과 영상 속에 숨은 정보를 추출해낸다는 것이지요. 이 논문은 이런 사실로부터 발칙한 상상을 합니다. 시각 시스템이 뛰어나기로 알려진 새, 그 중에서도 비둘기를 사용하여 유방암에 대한 판독을 시켜보자는 상상입니다. 딥-러닝이 아닌 비둘기-러닝인 셈입니다.

비둘기-러닝 학습환경

연구자들은 비둘기-러닝을 위해서 비둘기들에게 맞추면 모이를 주는 방식으로 학습을 진행했습니다.

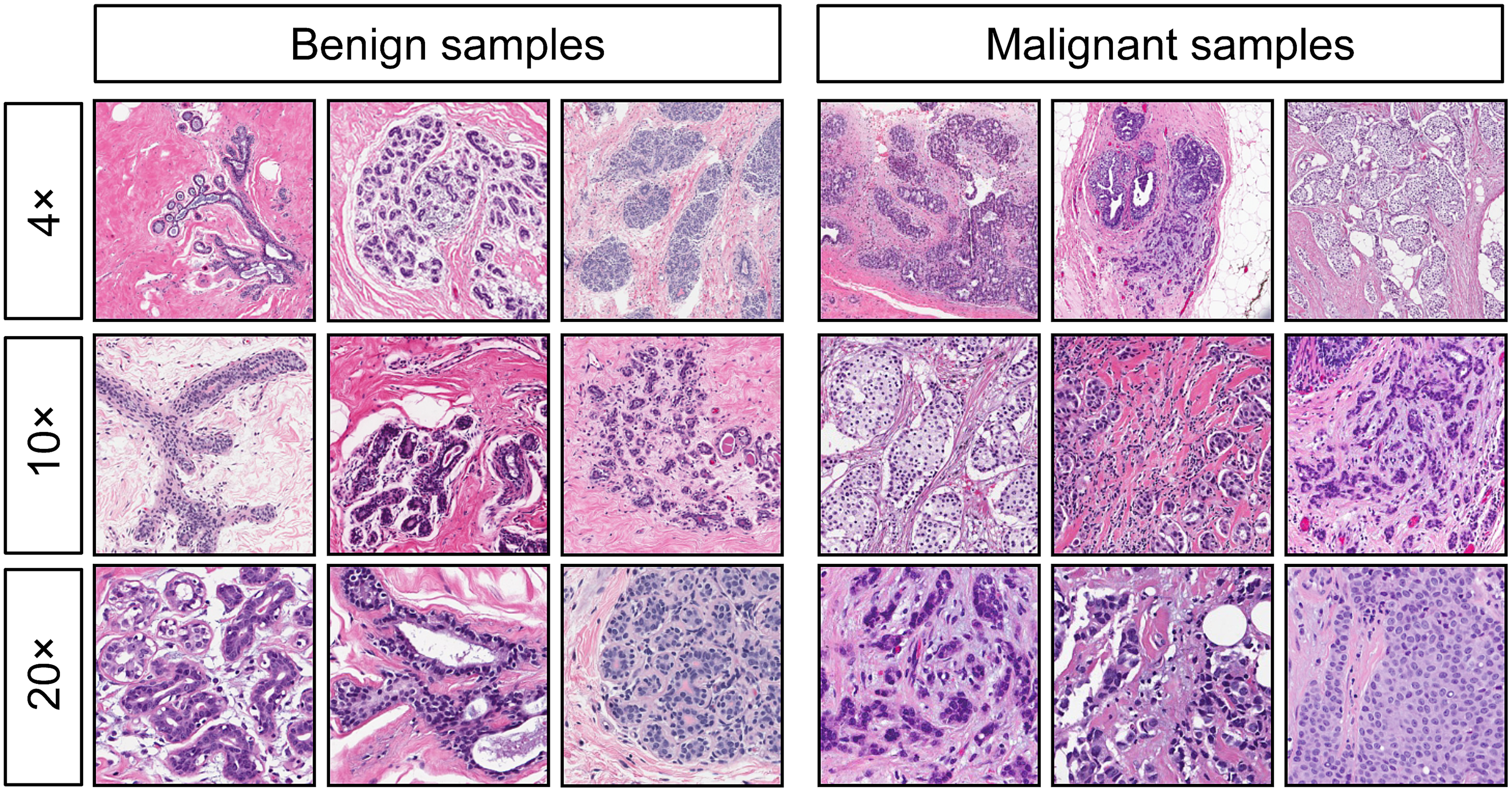

학습에 사용된 샘플들

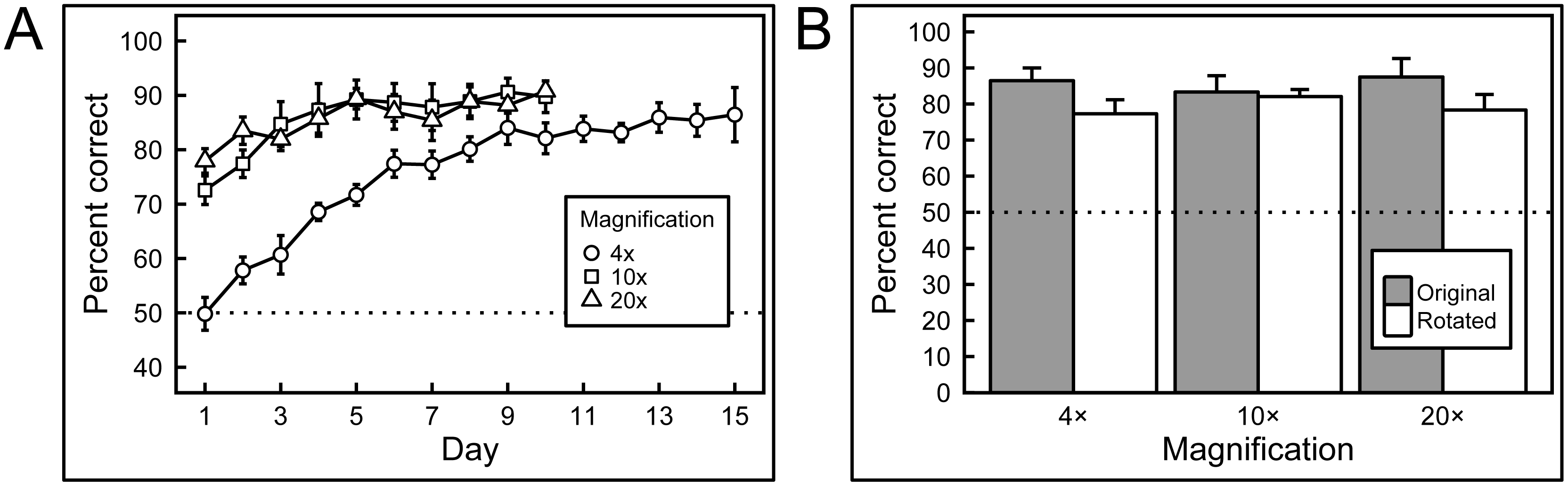

그랬더니 비둘기들은 놀랍게도 날이 갈수록 실력이 향상되었고, 종래에는 90% 정도의 정확도를 달성했습니다. (이왜진?)

(왼쪽) 날이 감에 따라 실력이 향상되는 그래프 (오른쪽) 병리 이미지 배율에 따른 비둘기들의 정확도

더 자세한 것이 관심가는 분들은 직접 논문을 읽어보시기로 하고, 여기서 위 질문을 다시 해 봅시다.

(의료)인공지능은 도메인 전문가(의사)를 대체할 수 있을까?

그런데, 위 논문을 읽고 나니 질문을 바꾸고 싶습니다.

비둘기는 도메인 전문가(의사)를 대체할 수 있을까?

모르긴 몰라도, 거의 대부분의 사람들에게 비둘기가 의사를 대체할 수 있냐고 물으면 코웃음을 칠 것입니다. 이제 좀 각이 나옵니다. 딥러닝은 의사를 대체하지는 못할 것 같군요.

그렇다면 의료에서 딥러닝, 다른 말로 인공지능의 역할은 무엇일까요? 저의 의견을 한 마디로 요약하자면

Toward POMAI

입니다. 그러면 POMAI가 무엇일까요? 스포일러 하는 것은 제 취향이 아니기 때문에 일단 글을 읽어나가며 POMAI가 무엇인지 생각해보고, 글의 말미에서 POMAI가 무엇인지 밝히도록 하겠습니다.

남들은 무엇을 했을까

딥러닝과 영상의학과

딥러닝의 의료에서의 역할에 대해서 지금부터는 고민해보도록 하겠습니다. 가장 쉽게 떠올릴 수 있는 딥러닝의 응용은

- 보조판독 혹은 second opinion

- 판독시간 단축으로 야기되는 의사들의 업무 효율성 증가

정도가 될 것입니다. 일단 국내 연구자들의 연구들부터 살펴봅시다.

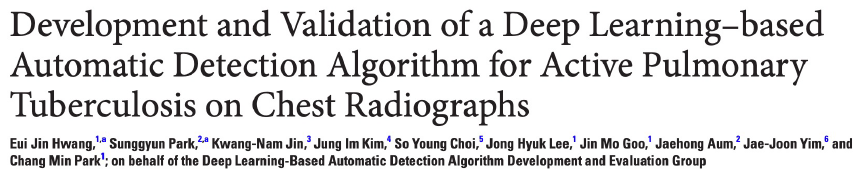

서울대학교병원 황의진 교수님의 연구입니다. (링크) 논문은 궁금한 분들만 읽어보시고, 결론을 이야기하면 다음 표 하나로 정리될 수 있을 것입니다.

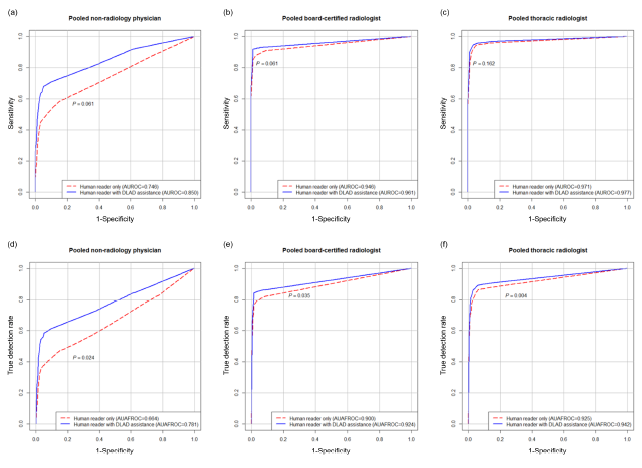

좌측 열은 영상의학과 의사가 아닌 의사들의 판독 정확도이고, 중간 열은 영상의학과 의사들의 판독 정확도, 오른쪽 열은 흉부영상 전문 영상의학과 의사들의 판독 정확도입니다. 빨간 색이 그냥 판독했을 때, 파란 색이 인공지능의 보조판독을 참고하여 판독했을 때의 AUC curve인데요, 재미있는 결론이 도출됩니다. 영상의학과 의사가 아닌 의사들(좌측 열)은 인공지능 제품을 통해 판독 정확도가 상승했고, 영상의학과 전문의는 판독 정확도가 크게 증가하지 않았습니다. 그런데 흉부 영상 전문의들은 사실상 판독 정확도의 차이가 없었습니다.

의료인공지능 초창기 연구들은 이러한 결론을 담는 논문들이 많습니다. 그래서 제 개인적으로는 결론내리기를

- 영상의학과 의사가 아닌 의사들은 판독에 도움을 많이 받는다.

- 영상의학과 전문의들은 판독에 조금 도움을 받는다.

- 해당 분과를 전공한(흉부, 두경부, 복부, …) 영상의학과 전문의들은 도움을 받지 못한다.

는 결론을 내렸습니다. 어찌 보면 당연한 이야기이지요. 정답(Ground Truth)을 만드는 사람들이 해당 분과 전공한 영상의학과 전문의니까요. 그러면 첫 번째 생각

- 보조판독 혹은 second opinion

에 대한 결론은

- 의료영상 판독 알고리즘의 수혜자는 영상의학과가 아닌 타과 전문의들이 될 것이다

가 될 수 있겠지요.

두 번째 생각에 대한 연구도 살펴봅시다.

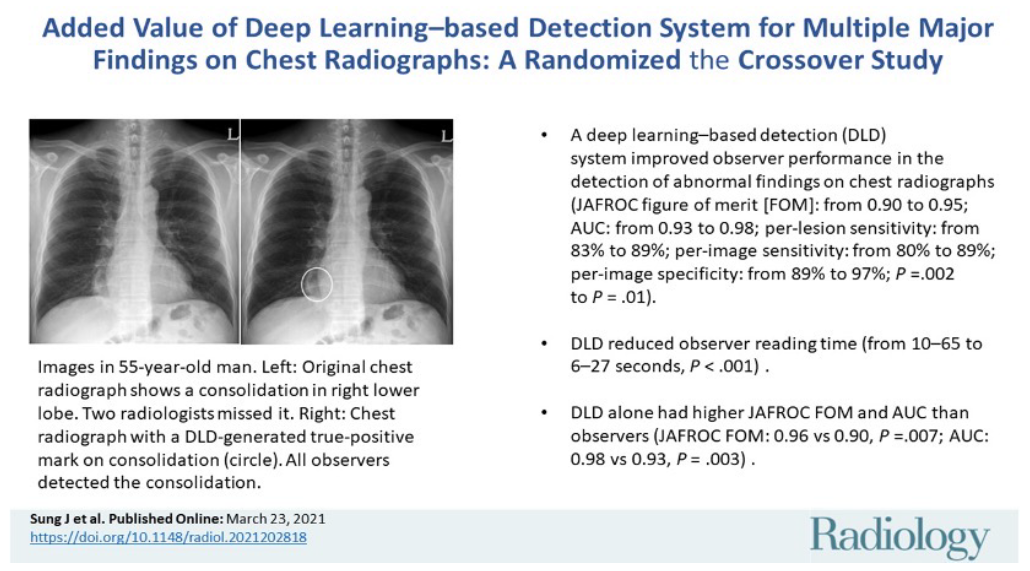

주식회사 VUNO에서 저술한 논문입니다. 영상의학계 최고 저널인 Radiology에 출간된 논문인데요, 딥러닝을 이용해서 흉부 판독을 진행했을 때 (1) 성능 향상이 있었고 (2) 판독 시간이 10-65초에서 6-27초로 감소했다는 결론을 내리고 있습니다. 즉, 영상의학과 의사들의 업무 효율성을 증가시켜준다는 것을 보인 논문이지요. 또한 VUNO에서는

이러한 논문도 저술했는데 결론은 역시나 비슷합니다. VUNO의 Bone Age라는 제품의 임상적 효용성을 연구한 논문이고

판독 시간이 18%, 40% 가량 감소했다는 말을 하고 있네요. 이러한 국내 연구들도 좋지만, 세계적인 기업들은 어떤 연구를 하고 있는지도 살펴봐야겠죠. 구글 헬스케어입니다.

세계로 눈을 돌려

구글이 한 것

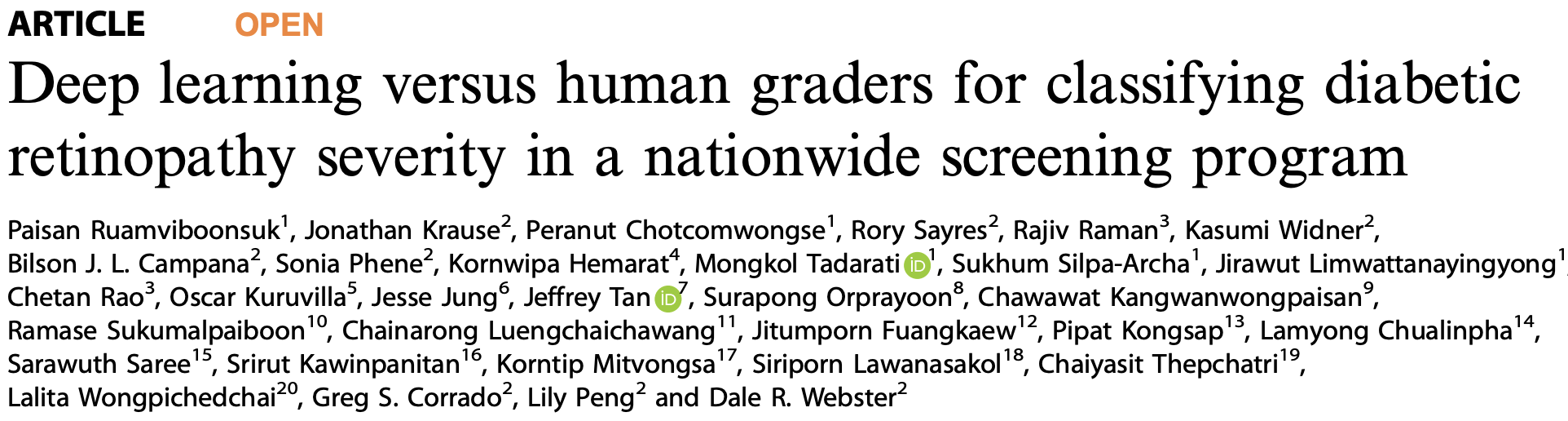

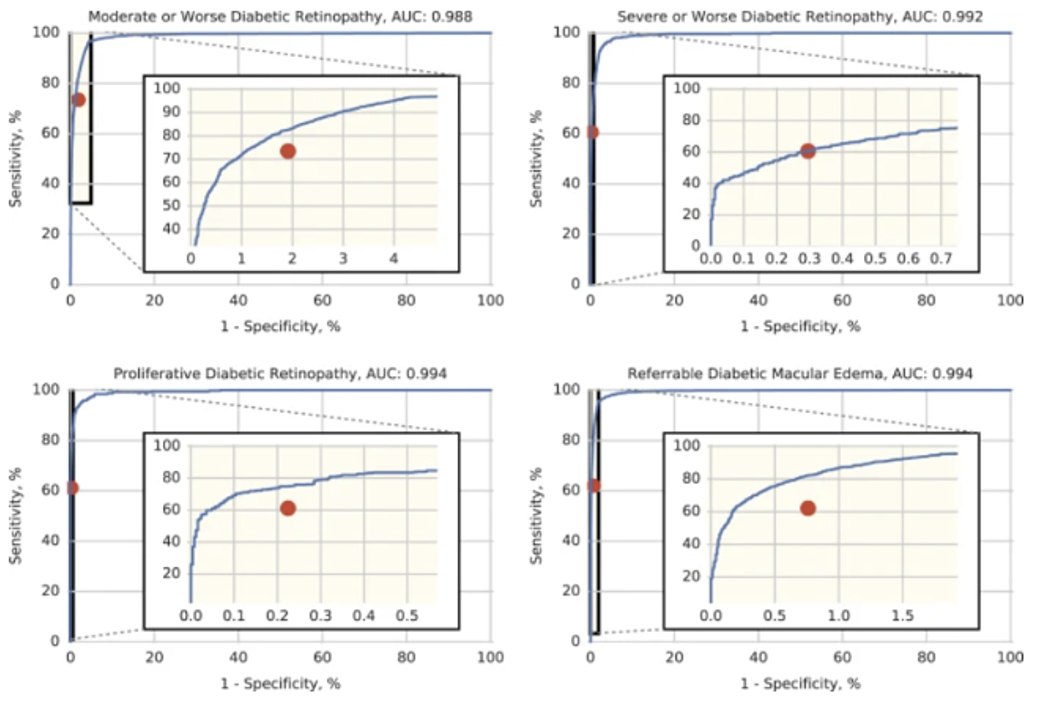

눈 검사인 망막안저검사(retinal fundus photograph)에서 당뇨병의 합병증인 당뇨병성 망막병증(diabetic retinopathy)을 검출해내는 알고리즘의 개발과 검증에 관한 논문입니다. (링크) 먼저 당뇨는 혈당이 높아지는 질환임을 상기합시다. 즉, 혈액에 당이 많고 이렇게 끈적해진 피는 전신을 타고 돌면서 많은 장기들에 손상을 입히는데요, 작은 혈관부터 망가지는 것이 일반적입니다. 결국 모세혈관이 먼저 망가진다는 것인데 모세혈관 중 가장 중요한 모세혈관이 눈의 망막 모세혈관입니다. 우리 속담에 몸이 1000냥이면 눈이 900냥이라는 말이 있을 정도로 눈은 우리 몸에서 중요한 장기임은 모두가 동의할 것입니다. 이 눈의 시각세포가 모여있는 망막에는 망막세포들을 먹여살리는 모세혈관이 많이 산재해 있는데 이들이 손상받으면 눈이 점점 나빠지고 종래에는 실명까지 오게 됩니다. 특히, 미국의 실명의 첫 번째 원인은 당뇨일 정도로 당뇨는 내분비내과에서 중요하게 다룰 뿐 아니라 안과에서도 중요한 질환입니다. (이 사실을 잘 기억해 놓으세요.) 따라서 당뇨를 전국적으로 잘 관리해서 실명을 예방하는 것이 미국 내분비내과와 안과의사들의 주요 목표 중 하나입니다.

자 다시 연구로 돌아가서 성능이야 당연히 JAMA에 실릴 정도니까 매우 높은 정확도를 보입니다. 그런데 이 연구는 구글만이 할 수 있는 연구였는데요, 그 이유는 128,175장의 안저사진을 54명의 미국 안과 전문의를 고용해서 모두 레이블링했기 때문(!!!)입니다. 아시다시피 미국은 의사의 몸값이 매우 높은데 이들을 54명이나 고용해서 한 명당 평균 2,300장이 넘는 이미지를 레이블링 시킨다는 것은 엄청난 돈을 쏟아붓는 연구임이 명백합니다. 따라서 구글만이 할 수 있는 연구라는 것이지요. 그렇다면 이 막대한 자본을 통해 구글은 무엇을 하려고 했을까요? 바로 후속 논문에서 그 이유가 밝혀집니다.

전문의만큼 잘 하는 딥러닝 알고리즘을 전국적인 스크리닝 검사에 도입했다는 연구입니다. (링크) 이 때 선택한 나라는 태국(Thailand)인데요, 태국은 7000만명 정도의 인구를 가진 나라인데 1500명의 안과 전문의들이 있고 이 중 오직 200명만이 망막을 전공한 안과 전문의입니다. 위에서 본 망막안저검사를 전문으로 하는 안과 전문의들이 200명밖에 없다는 뜻이지요. 문제는 이들 200명 중 절반인 약 100여명은 방콕에 거주하고 나머지 100명이 전국 각지에 흩어있게 된다는 것입니다. 반면 당뇨 환자는 추산 약 450만명 정도로 매우 낮은 의료 접근성을 보이고 있습니다. 논문의 Introduction을 보면 다음과 같이 서술합니다.

In Thailand, there are 1500 ophthalmologists, including 200 retinal specialists, who provide ophthalmic care to approximately 4.5 million patients with diabetes. Half of the ophthalmologists and retinal specialists practice in Bangkok, the capital of the country, while a majority of patients with diabetes live in areas 100 km or more from provincial hospitals, where ophthalmologists typically practice. The latest Thailand National Survey of Blindness conducted in 2006–2007 showed that 34% of patients with diabetes had low vision or blindness in either eye. DR was and continues to be the most common retinal disease that causes bilateral low vision.

그래서 구글 연구진들은 앞서 개발한 인공지능 알고리즘을 방콕에 전국적으로 적용하는 후속 연구를 진행했습니다.

성능이야 인간만큼 잘 하는 것을 보이는 AUROC curve로 증명이 되었습니다. 자 여기서 잠시 생각을 해 봅시다. 구글이 어마어마한 돈을 쏟아부으며 이러한 연구를 한 것은 단순히 공익만을 위해서일까요? 아닐 것입니다. 구글은 영리를 추구하는 기업이고 Google Health 또한 수익을 창출하는 것을 목표로 하겠죠. 이러한 연구로부터 구글은 의료 접근성이 떨어지는 제3세계의 의료를 하고 싶어하는 것으로 추측할 수 있습니다. 저 논문 이후의 상황은 어땠을까요? 저도 이 글을 적으며 찾아보다 보니 이런 리뷰가 있었습니다. (링크)

(인생은 실전이야 구글아) 이 글을 살펴보면 몇 가지 치명적인 구글 팀의 문제가 있었습니다.

- 잘 찍힌 high-quality 이미지만 판독이 가능했다.

- Real-world에서는, 특히나 안저사진만 전문적으로 찍는 촬영 기사나 안과 의사가 없는 상황에서는 상대적으로 안저사진에 대한 전문성이 떨어지는 간호사와 같은 사람들이 촬영을 하기 때문에 잘못 찍힌 사진들이 많게 됩니다.

- 그래서 이 제품을 태국에 적용했을 때 20%가량의 이미지가 판독 불가로 나왔다고 합니다. 이렇게 판독 불가한 사진을 찍은 환자들은 다른 날 다른 병원에 또 가서 사진을 찍으라는 지시를 받았고 이것은 절대 바람직하지 않겠죠. 특히나 환자의 사진이 정상처럼 보이는데 단순히 판독 불가로 떠서 다른 날 다른 병원에 가는 상황은 그 누구도 원치 않을 것입니다.

- 클라우드 시스템의 문제점

- 태국과 같은 개발도상국에서 인터넷 환경은 썩 좋지 않습니다. 구글은 보안 이슈 때문인지 무엇 때문인지 클라우드 서비스로 솔루션을 제공했고 좋지 않은 인터넷 환경 때문에 업로드가 실패하고 느려지는 경우가 빈번했다고 합니다. 심지어는 하루에 10명 정도밖에 못보는 의원도 있었다고 할 정도니까요.

그래서 구글은 새로운 workflow를 생각하고 있다고 글은 전합니다.

자, 벌써 녹록치 않습니다. 구글 같은 일류 기업도 의료인공지능으로 세상을 더 나은 곳으로 바꾸는 것이 쉽지 않네요. 미리 spoiler하자면, 위에서 언급한 비-영상의학과 의사들의 정확도 향상이나 의사들의 판독 시간 단축(효율성 증가)같은 것으로는 의료인공지능 회사 입장에서 돈을 벌기가 쉽지 않은걸 넘어서 거의 불가능에 가깝다고 해도 과언이 아닐 것입니다.

그렇다면 어떻게 의료인공지능으로 세상을 더 나은 곳으로 바꿀 수 있을까요? Part 2에서는 이 질문에 대해 조금 더 가까이 다가가볼 것입니다.

To be continued…